目录

一、准备工作

二、代理IP的选择与使用

三、使用Swift编写唯品会商品爬虫

四、数据解析与处理

五、注意事项与优化建议

六、总结

一、准备工作

在开始编写爬虫之前,需要准备一些工具和库,以确保数据抓取的顺利进行。以下是所需的工具和库:

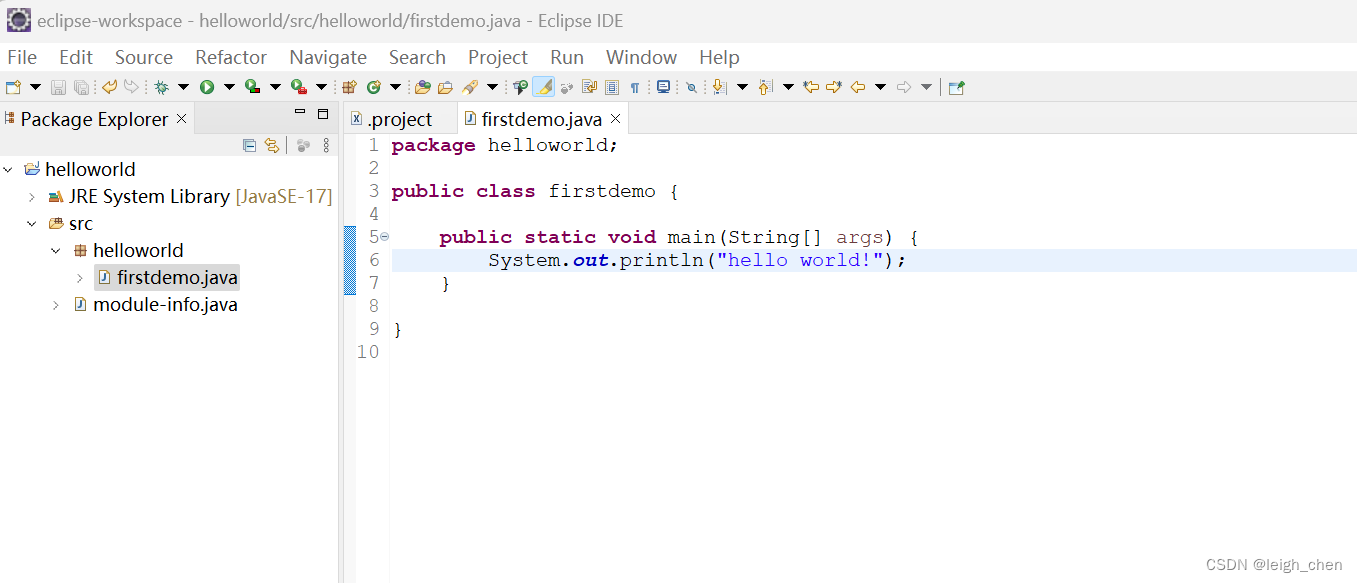

Swift语言环境:确保你的开发环境中安装了Swift,并且版本符合要求。

Alamofire库:用于发起HTTP请求和处理响应。可以通过CocoaPods或Swift Package Manager进行安装。

Kanna库:用于解析HTML文档。同样可以通过CocoaPods或Swift Package Manager进行安装。

代理IP服务:选择一个可靠的代理IP服务,例如站大爷代理IP,用于隐藏你的真实IP地址,提高数据抓取的效率和安全性。

二、代理IP的选择与使用

代理IP在爬虫编写中起着至关重要的作用,它可以隐藏你的真实IP地址,避免被目标网站封禁。以下是选择和使用代理IP的步骤:

选择代理IP服务:选择一个可靠的代理IP服务提供商,确保其提供的IP地址匿名、稳定、快速且可访问目标网站。

获取代理IP:从代理IP服务提供商处获取可用的代理IP地址和端口号。

设置代理IP:在发起HTTP请求时,通过设置请求头部的http://或https://字段来使用代理IP。具体设置方式取决于你所使用的HTTP库和网络环境。

定期更换代理IP:为了降低被封禁的风险,应定期更换使用的代理IP。

考虑使用SOCKS代理:如果目标网站支持SOCKS代理,可以考虑使用SOCKS代理来进行数据抓取,以提高匿名性和安全性。

三、使用Swift编写唯品会商品爬虫

在准备好工具和库之后,可以开始编写唯品会商品爬虫。以下是编写爬虫的步骤和代码示例:

分析目标网页结构:首先,你需要分析唯品会商品页面的HTML结构,了解所需数据的标签和属性。可以使用网页开发者工具(如Chrome开发者工具)来查看HTML结构。

构建URL和请求参数:根据所需数据的页面位置,构建适当的URL和请求参数。可以使用唯品会的商品分类页面作为入口,通过解析分类页面的URL结构来获取商品详情页面的URL构造方式。

发起HTTP请求并获取响应:使用Alamofire库发起GET请求,并处理响应数据。将响应数据解析为字符串,以便后续处理。

解析HTML并提取数据:使用Kanna库解析HTML文档,并使用XPath或CSS选择器定位到所需的数据元素。提取所需的数据,如商品标题、价格、描述等。

处理异常和错误:在数据抓取过程中,可能会遇到各种异常和错误情况,如网络连接问题、超时、解析错误等。应添加适当的错误处理逻辑,以便在出现问题时能够优雅地处理并记录错误信息。

存储和输出数据:将提取的数据存储到本地文件、数据库或通过网络发送到其他服务器进行处理。根据实际需求选择适当的存储和输出方式。

以下是一个简单的代码示例,展示了如何使用Alamofire和Kanna库来抓取唯品会商品详情:

import Alamofire

import Kanna

class VIPGoodsCrawler {

private let baseURL = "https://www.vip.com" // 唯品会商品详情页的基础URL

private let proxyHost = "https://www.zdaye.com" // 代理服务器地址

private let proxyPort = 8080 // 代理服务器端口号

// 定义一个请求闭包来处理代理设置和其他自定义配置

private let requestClosure: (URLRequestConvertible) -> URLRequest = { $0.urlRequest(baseURL: self.baseURL, proxy: Proxy(host: self.proxyHost, port: self.proxyPort)) }

// 发起HTTP请求并获取HTML内容

func fetchProductDetails(productURL: URLConvertible, completion: @escaping (Result<HTMLDocument, Error>) -> Void) {

Alamofire.request(productURL, closure: requestClosure).responseHTML { response in

guard let html = response.result.value else {

completion(.failure(NSError(domain: "", code: 0, userInfo: [NSLocalizedDescriptionKey: "Failed to fetch HTML"])))

return

}

completion(.success(html))

}

}

// 解析HTML并提取商品详情数据(根据实际情况调整XPath或CSS选择器)

func extractProductDetails(html: HTMLDocument)

-> {

title: "Product Title",

price: "Product Price",

description: "Product Description"

}

以上代码示例中,我们定义了一个VIPGoodsCrawler类,用于处理唯品会商品详情的抓取和解析。该类使用了Alamofire库来发起HTTP请求,Kanna库来解析HTML文档,并使用代理IP来隐藏真实IP地址。

在实际使用中,你需要根据唯品会商品页面的实际HTML结构调整XPath或CSS选择器,以准确提取所需的数据元素。同时,还需要处理各种异常和错误情况,例如网络连接问题、超时、解析错误等。

四、数据解析与处理

在获取到HTML文档后,需要对其进行解析,以提取所需的数据。Kanna库提供了方便的API来进行HTML解析。以下是一个简单的示例,展示了如何使用Kanna库提取商品标题、价格和描述:

// 解析HTML并提取商品详情数据

extension VIPGoodsCrawler {

func extractProductDetails(html: HTMLDocument) -> [String: String] {

var productDetails: [String: String] = [:]

// 提取商品标题

if let titleElement = html.xpath("//h1[@class='product-title']").first {

productDetails["title"] = titleElement.text

}

// 提取商品价格

if let priceElement = html.xpath("//span[@class='product-price']").first {

productDetails["price"] = priceElement.text

}

// 提取商品描述

if let descriptionElement = html.xpath("//div[@class='product-description']").first {

productDetails["description"] = descriptionElement.text

}

return productDetails

}

}在上述代码中,我们使用Kanna库的xpath()方法来定位到所需的HTML元素,并提取其文本内容。根据唯品会商品页面的实际HTML结构,你需要调整XPath表达式以准确获取所需的数据。

五、注意事项与优化建议

在编写和使用爬虫时,需要注意以下几点:

遵守法律法规:确保你的爬虫行为符合法律法规,尊重目标网站的知识产权和隐私权。不要抓取敏感信息或滥用目标网站的资源。

合理使用代理IP:代理IP可以帮助你隐藏真实IP地址,但过度使用或滥用代理IP可能会被目标网站封禁。合理安排和使用代理IP,避免频繁更换IP地址或短时间内大量请求。

尊重目标网站的Robots协议:大多数网站都会在其Robots协议中明确禁止或限制爬虫行为。确保你的爬虫遵守目标网站的Robots协议,避免对目标网站造成不必要的负担或干扰。

优化代码和性能:尽可能优化你的爬虫代码,提高数据抓取的效率和准确性。同时,注意控制资源消耗,避免对目标网站或自身服务器造成过大的负载。

处理异常和错误:在数据抓取过程中,可能会遇到各种异常和错误情况。添加适当的错误处理逻辑,以便在出现问题时能够优雅地处理并记录错误信息。

保护数据安全:确保你的数据存储和处理方式符合安全标准,防止数据泄露和被恶意利用。对敏感数据进行加密和脱敏处理,确保数据安全。

六、总结

爬虫技术作为数据获取的重要手段之一,在许多领域都有广泛的应用。在使用爬虫技术时,需要注意法律法规、目标网站的Robots协议、数据安全和隐私保护等方面的问题。