前言

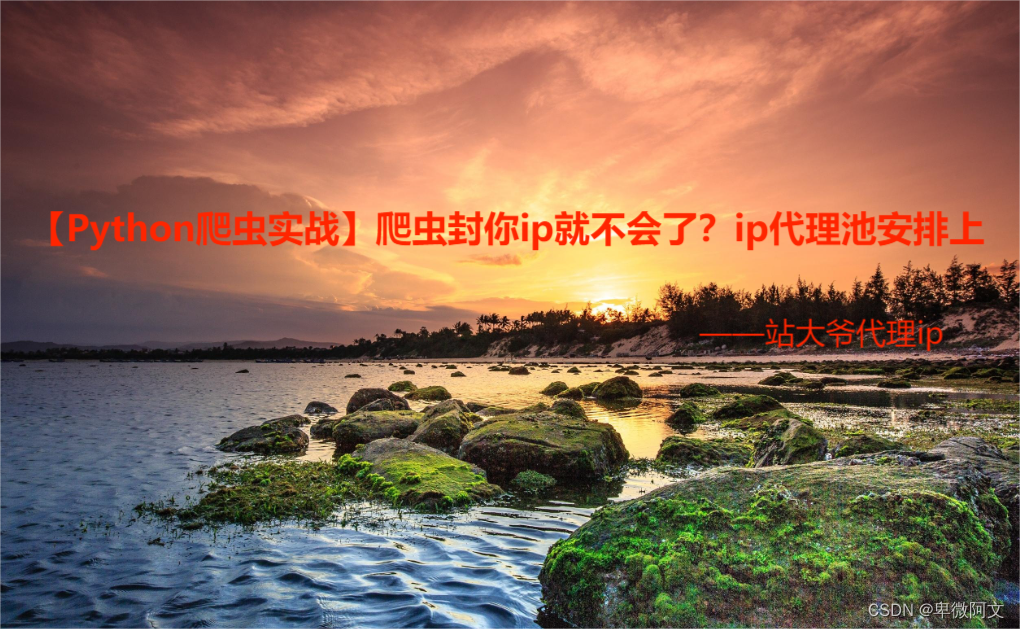

在进行网络爬取时,使用代理是经常遇到的问题。由于某些网站的限制,我们可能会被封禁或者频繁访问时会遇到访问速度变慢等问题。因此,我们需要使用代理池来避免这些问题。本文将为大家介绍如何使用IP代理池进行爬虫,并带有代码和案例。

1. 什么是IP代理池

IP代理池是一种能够动态获取大量代理IP地址的服务,通过不断更新代理IP列表和检测可用性,避免爬虫访问被封禁。代理池通常由多个代理服务器组成,而这些代理服务器提供的IP地址是不断变化的。

2. 如何使用IP代理池进行爬虫

使用IP代理池进行爬虫有以下几个步骤:

2.1 获取代理IP

获取代理IP的方法有多种,比如购买第三方代理服务、自己搭建代理服务器、爬取免费代理网站等。其中,爬取免费代理网站是最为常见的方法,但是免费代理大多数不稳定,质量也参差不齐,所以购买第三方代理服务或者自己搭建代理服务器会更加可靠。

2.2 构建代理池

将获取到的代理IP存储在一个代理池中,通常可以使用List或Queue等数据结构存储,然后按照一定的时间间隔进行检测,将失效的IP进行移除或重新获取新的IP存入池中。

2.3 在爬虫中使用代理IP

在爬虫的请求中使用代理IP,可以使用requests库或者Scrapy框架中的代理中间件进行实现。以requests库为例,需要在请求头中添加代理IP,如下所示:

python">import requests

proxies = {

'http': 'http://ip:port',

'https': 'http://ip:port',

}

response = requests.get(url, proxies=proxies)

2.4 异常处理

在爬虫的过程中,由于代理IP的稳定性和可用性不同,可能会遇到一些错误或异常情况。比如请求超时、代理IP失效、网络波动等。这时我们需要进行异常处理,可以设置重试请求、更换代理IP等方式来保证程序的正常运行。

3. 代码实现

以下是一个简单的IP代理池实现代码:

python">import requests

import threading

import time

from queue import Queue

# 获取代理IP

def get_proxies():

# 这里使用免费代理网站进行获取,实际使用中需要替换成其他方式获取

url ="https://www.zdaye.com/"

response = requests.get(url).json()

return [f"{i['protocol']}://{i['ip']}:{i['port']}" for i in response['data']['data_list']]

# 测试代理IP是否可用

def test_proxy(proxy, q):

try:

proxies = {

'http': proxy,

'https': proxy

}

response = requests.get('http://httpbin.org/ip', proxies=proxies, timeout=5)

if response.status_code == 200:

q.put(proxy)

print(f"{proxy}可用")

except:

print(f"{proxy}不可用")

# 构建代理池

def build_proxies_pool():

proxies_list = get_proxies()

pool = Queue()

threads = []

# 开启多个线程对代理IP进行测试

for proxy in proxies_list:

t = threading.Thread(target=test_proxy, args=(proxy, pool))

threads.append(t)

t.start()

for t in threads:

t.join()

return pool

# 在爬虫中使用代理IP

def spider_request(url, proxies):

try:

response = requests.get(url, proxies={'http': proxies, 'https': proxies}, timeout=5)

if response.status_code == 200:

print(response.text)

except:

print(f"{proxies}请求失败")

if __name__ == '__main__':

while True:

pool = build_proxies_pool()

if not pool.empty():

proxies = pool.get()

spider_request('http://httpbin.org/ip', proxies)

time.sleep(5)4. 案例分析

以爬取知乎用户信息为例,演示IP代理池的使用。

python">import requests

import random

import time

# 构造请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

# 获取代理IP

def get_proxies():

# 这里使用免费代理网站进行获取,实际使用中需要替换成其他方式获取

url ="https://www.zdaye.com/"

response = requests.get(url).json()

return [f"{i['protocol']}://{i['ip']}:{i['port']}" for i in response['data']['data_list']]

# 构造代理池

proxies_pool = get_proxies()

# 爬虫主体程序

def get_user_info(user_url):

# 从代理池中随机选择一个代理IP

proxies = random.choice(proxies_pool)

try:

response = requests.get(user_url, headers=headers, proxies={'http': proxies, 'https': proxies})

if response.status_code == 200:

print(response.text)

except:

print(f"{proxies}请求失败")

if __name__ == '__main__':

user_list = ['https://www.zhihu.com/people/xie-ke-bai-11-86-24-2/followers',

'https://www.zhihu.com/people/gong-xin-10-61-53-51/followers',

'https://www.zhihu.com/people/y-xin-xin/followers']

for user_url in user_list:

get_user_info(user_url)

time.sleep(5)以上是一个简单的知乎用户信息爬虫程序,其中使用了IP代理池,避免了访问速度受限和访问被封禁的问题。

5. 总结

本文介绍了如何使用IP代理池避免被封禁和访问受限的问题,通过获取代理IP、构建代理池、在爬虫中使用代理IP以及异常处理等步骤进行实现。同时,结合了一个简单的案例进行演示,希望对大家有所帮助。

![[Linux 基础] linux基础指令(1)](https://img-blog.csdnimg.cn/1797ef1c6da849a8ad03f6b78dbb5ceb.png)