文章目录

- 一、爬取目标

- 二、展示结果数据

- 三、编写爬虫代码

- 3.1 请求头和cookie

- 3.2 分析请求地址

- 3.3 分析页面元素

- 3.4 获取真实地址

- 3.5 保存结果数据

- 四、同步讲解视频

- 五、附完整源码

一、爬取目标

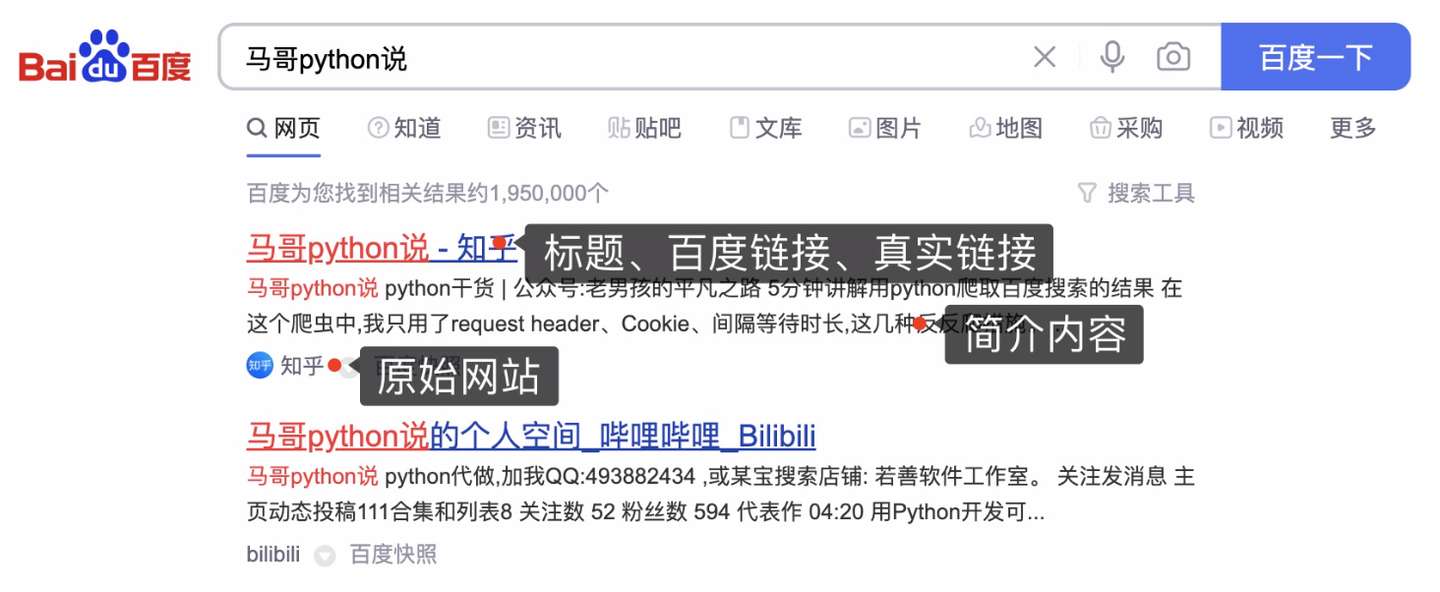

本次爬取目标是,百度搜索结果数据。以搜索”马哥python说“为例:

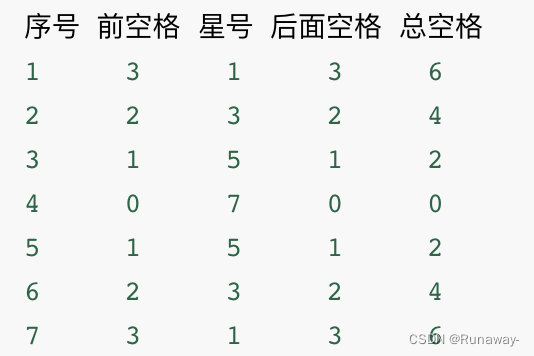

爬取字段,含:

页码、标题、百度链接、真实链接、简介、网站名称。

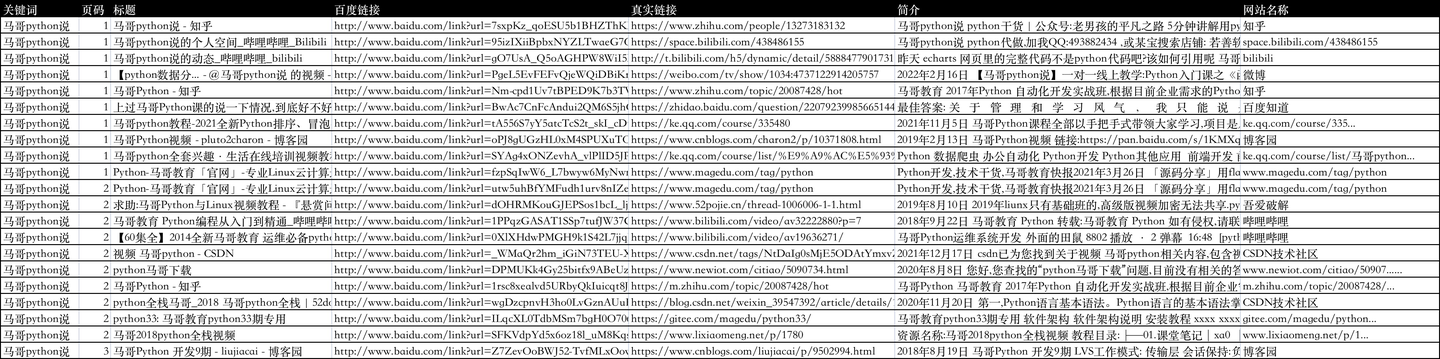

二、展示结果数据

爬取结果如下:

三、编写爬虫代码

3.1 请求头和cookie

首先,导入需要用到的库:

python">import requests # 发送请求

from bs4 import BeautifulSoup # 解析页面

import pandas as pd # 存入csv数据

import os # 判断文件存在

from time import sleep # 等待间隔

import random # 随机

import re # 用正则表达式提取url

定义一个请求头:

python"># 伪装浏览器请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36",

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9",

"Accept-Language": "zh-CN,zh;q=0.9,en-US;q=0.8,en;q=0.7",

"Connection": "keep-alive",

"Accept-Encoding": "gzip, deflate, br",

"Host": "www.baidu.com",

# 需要更换Cookie

"Cookie": "BIDUPSID=729E480F1B8CEB5347D8572AE6495CFA; PSTM=1645237046; BAIDUID=729E480F1B8CEB53DEEB6344B7C88A22:FG=1; BD_UPN=123253; BDORZ=B490B5EBF6F3CD402E515D22BCDA1598; __yjs_duid=1_695315baa9a328fc73db6db6ba9ee8781645357087938; MSA_WH=1324_311; H_PS_PSSID=35106_31660_35765_34584_35872_35818_35948_35954_35315_26350_22159; H_PS_645EC=ab89Uk1B6EQVOEBnfF64C5jyWp40Rge9HGeQ8Q2fEodX81kjh6WtOKBhR2A; BAIDUID_BFESS=729E480F1B8CEB53DEEB6344B7C88A22:FG=1; BA_HECTOR=2g8g040k818g0l21a31h1g5g60r; baikeVisitId=9a933a90-dc5c-4192-93d2-10526d401267; WWW_ST=1645745708722"

}

Cookie是个关键,如果不加Cookie,响应码可能不是200,获取不到数据,而且Cookie值是有有效期的,需要定期更换,如果发现返回无数据或响应码非200,尝试替换最新的Cookie。

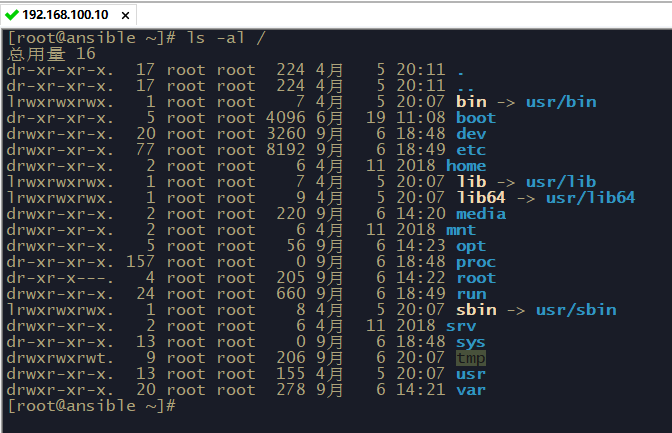

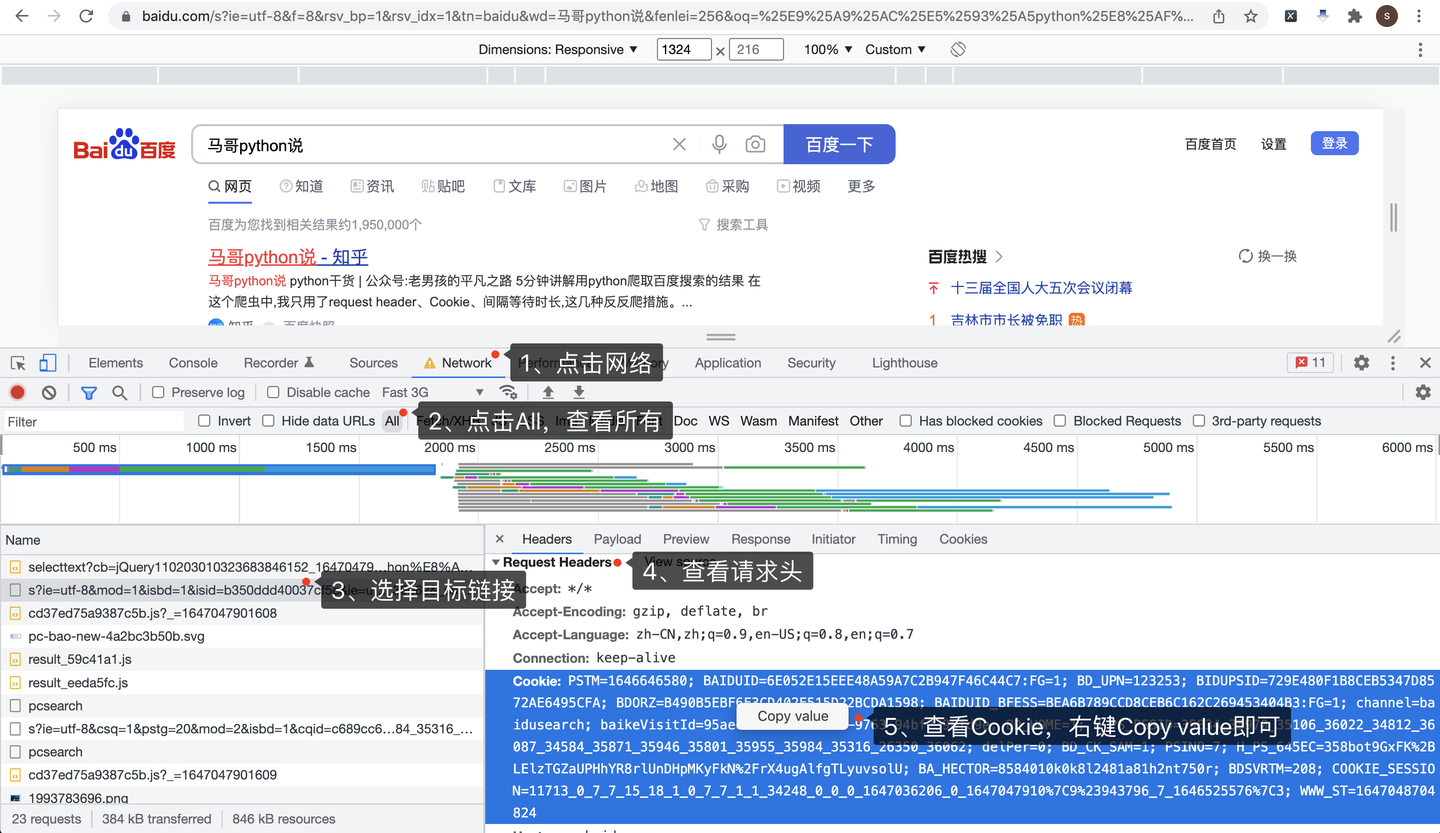

怎么获取到Cookie呢?打开Chrome浏览器,访问百度页面,按F12进入开发者模式:

按照图示顺序,依次:

- 点击Network,进入网络页

- 点击All,查看所有网络请求

- 选择目标链接,和地址栏里的地址一致

- 查看Request Headers请求头

- 查看请求头里的Cookie,直接右键,Copy value,粘贴到代码里

3.2 分析请求地址

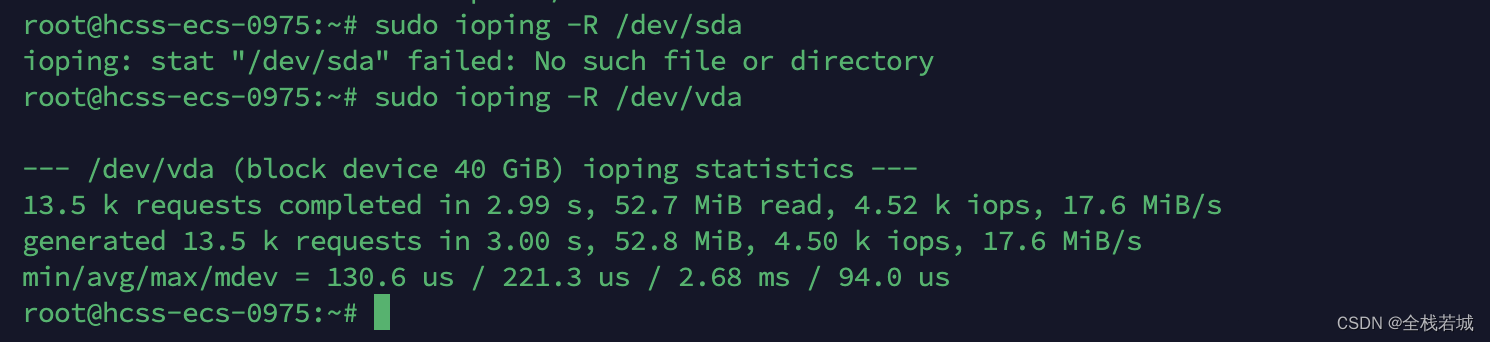

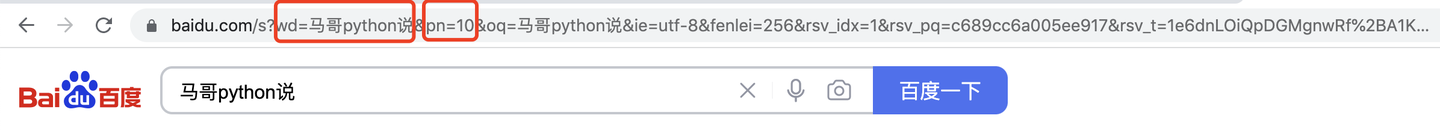

然后,分析页面请求地址:

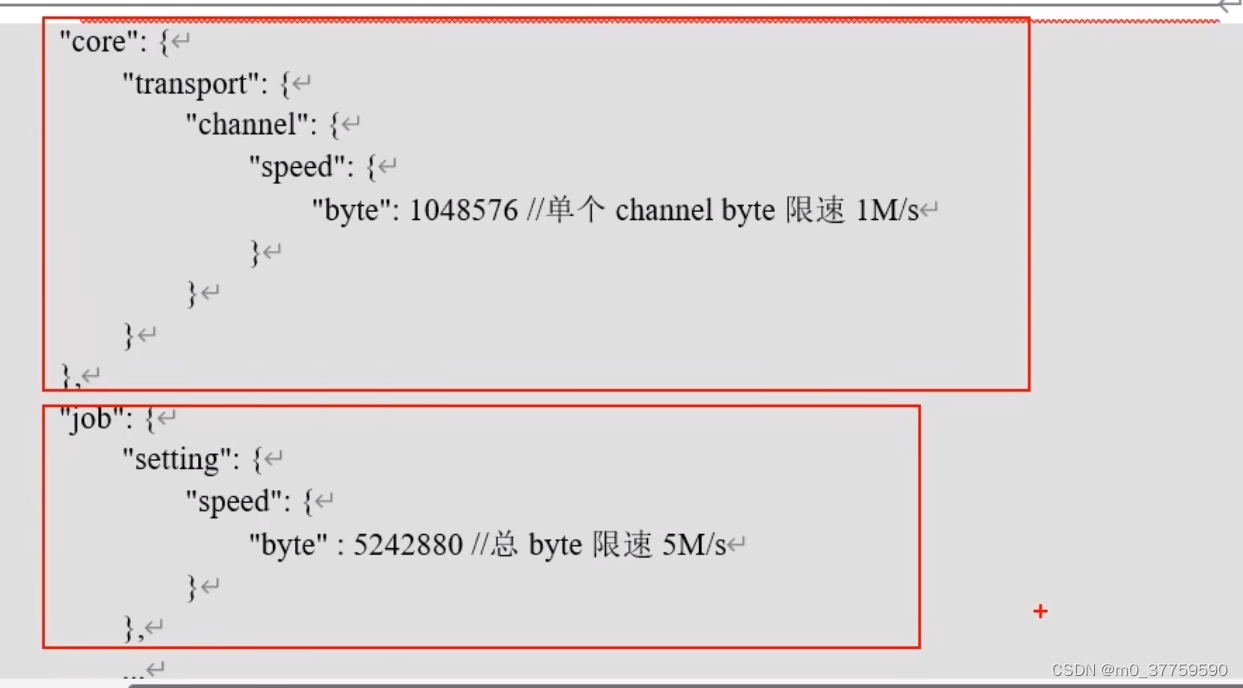

wd=后面是搜索关键字"马哥python说",pn=后面是10(规律:第一页是0,第二页是10,第三页是20,以此类推),其他URL参数可以忽略。

3.3 分析页面元素

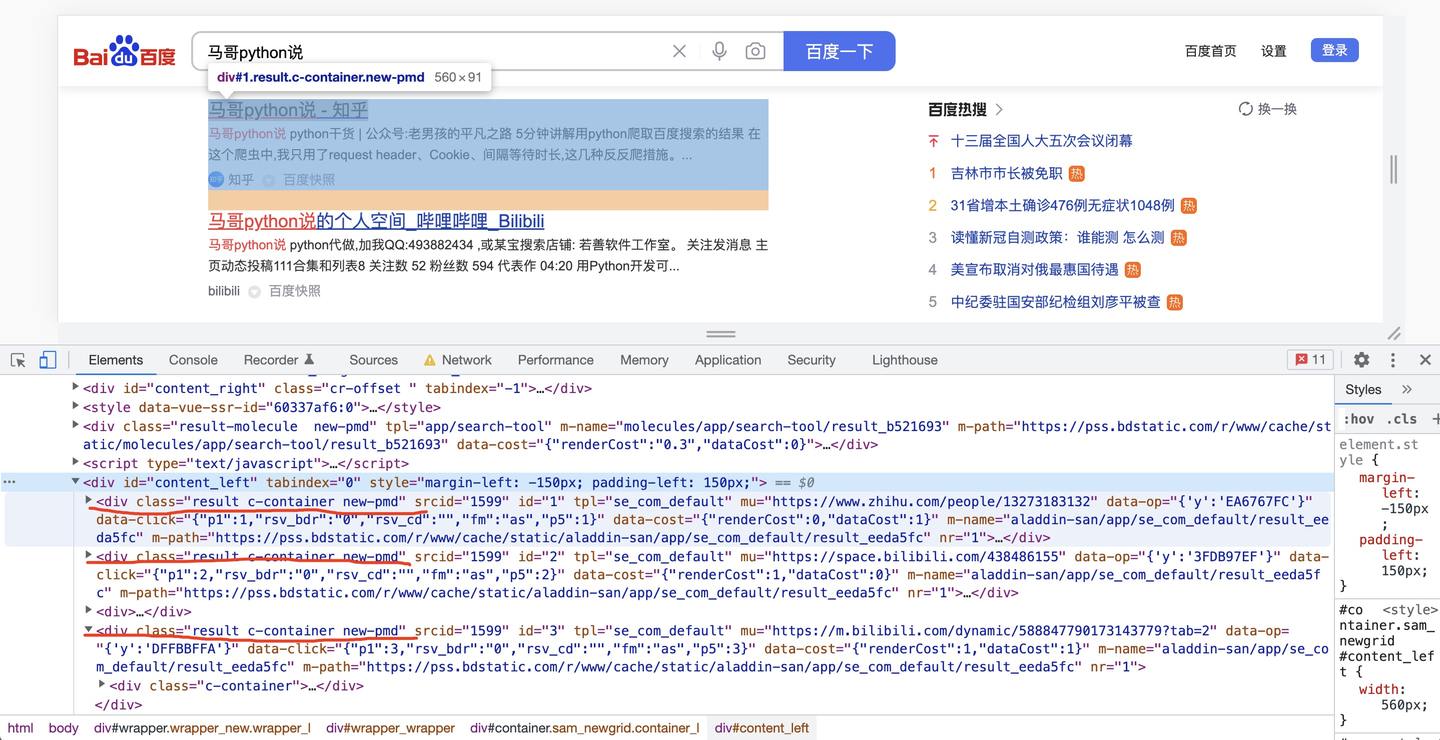

然后,分析页面元素,以搜索结果标题为例:

每一条搜索结果,都是class=“result c-container new-pmd”,下层结构里有简介、链接等内容,解析内部子元素不再赘述。

所以根据这个逻辑,开发爬虫代码。

python"># 获得每页搜索结果

for page in range(v_max_page):

print('开始爬取第{}页'.format(page + 1))

wait_seconds = random.uniform(1, 2) # 等待时长秒

print('开始等待{}秒'.format(wait_seconds))

sleep(wait_seconds) # 随机等待

url = 'https://www.baidu.com/s?wd=' + v_keyword + '&pn=' + str(page * 10)

r = requests.get(url, headers=headers)

html = r.text

print('响应码是:{}'.format(r.status_code))

soup = BeautifulSoup(html, 'html.parser')

result_list = soup.find_all(class_='result c-container new-pmd')

print('正在爬取:{},共查询到{}个结果'.format(url, len(result_list)))

3.4 获取真实地址

其中,获取到的标题链接,一般是这种结构:

http://www.baidu.com/link?url=7sxpKz_qoESU5b1BHZThKRAnXxPngB5kx1nZdUBCaXh7a4BgUgx9Zz-IqpeqDZTOIjvfY0u6ebnJdVWIfm5Tz_

这显然是百度的一个跳转前的地址,不是目标地址,怎么获取它背后的真实地址呢?

向这个跳转前地址,发送一个请求,然后逻辑处理下:

python">def get_real_url(v_url):

"""

获取百度链接真实地址

:param v_url: 百度链接地址

:return: 真实地址

"""

r = requests.get(v_url, headers=headers, allow_redirects=False) # 不允许重定向

if r.status_code == 302: # 如果返回302,就从响应头获取真实地址

real_url = r.headers.get('Location')

else: # 否则从返回内容中用正则表达式提取出来真实地址

real_url = re.findall("URL='(.*?)'", r.text)[0]

print('real_url is:', real_url)

return real_url

如果响应码是302,就从响应头中的Location参数获取真实地址。

如果是其他响应码,就从响应内容中用正则表达式提取出URL真实地址。

3.5 保存结果数据

把爬取到的数据,保存到csv文件:

python">df = pd.DataFrame(

{

'关键词': kw_list,

'页码': page_list,

'标题': title_list,

'百度链接': href_list,

'真实链接': real_url_list,

'简介': desc_list,

'网站名称': site_list,

}

)

if os.path.exists(v_result_file):

header = None

else:

header = ['关键词', '页码', '标题', '百度链接', '真实链接', '简介', '网站名称'] # csv文件标头

df.to_csv(v_result_file, mode='a+', index=False, header=header, encoding='utf_8_sig')

print('结果保存成功:{}'.format(v_result_file))

to_csv的时候需加上选项(encoding=‘utf_8_sig’),否则存入数据会产生乱码,尤其是windows用户!

四、同步讲解视频

讲解视频:

【逐行代码讲解】讲解教程:用python爬百度搜索结果

五、附完整源码

完整源码获取:【python爬虫案例】用python爬取百度的搜索结果!2023.3发布