Python爬虫是一种自动化程序,可以模拟人类用户访问网页,获取网页中的内容。爬虫在信息采集、数据分析和网络监测等领域有着广泛的应用。在爬虫过程中,解析网页内容是非常重要的一步。

Python提供了许多强大的库和工具,用于解析网页内容。其中,BeautifulSoup库是一个流行的库,可以帮助我们方便地解析HTML和XML文档。在本文中,我们将介绍如何使用Python和BeautifulSoup库来解析网页内容,并提取我们所需的信息。

安装

首先,我们需要安装BeautifulSoup库。可以使用pip命令来安装:

pip install beautifulsoup4

安装完成后,我们就可以开始解析网页内容了。下面是一个简单的例子,演示了如何使用BeautifulSoup来解析网页内容。

python">from bs4 import BeautifulSoup

import requests

# 发起请求,获取网页内容

url = 'https://example.com'

response = requests.get(url)

html_content = response.text

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'html.parser')

# 解析网页内容

title_tag = soup.find('title')

print('网页标题:', title_tag.text)

# 查找所有的<a>标签,并提取链接和文本内容

a_tags = soup.find_all('a')

for a_tag in a_tags:

print('链接:', a_tag['href'])

print('文本:', a_tag.text)

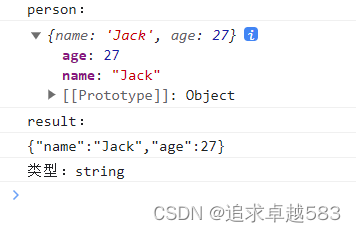

在上面的例子中,我们首先使用requests模块发起请求,获取网页的HTML内容。然后,我们使用BeautifulSoup()方法创建一个BeautifulSoup对象,传入网页的HTML内容和解析器类型。在这个例子中,我们使用了html.parser解析器。

接下来,我们使用find()方法查找网页中的<title>标签,并使用text属性获取标签内的文本内容。然后,我们使用find_all()方法查找所有的<a>标签,并使用循环遍历打印每个标签的链接和文本内容。

除了查找标签和提取文本内容,我们还可以根据标签的属性来查找内容。例如,我们可以使用find_all()方法的attrs参数来指定属性和属性值。

python"># 查找class属性为"intro"的<div>标签

div_tags = soup.find_all('div', attrs={'class': 'intro'})

for div_tag in div_tags:

print(div_tag.text)

在上面的例子中,我们使用find_all()方法的attrs参数来查找class属性为"intro"的<div>标签,并使用循环遍历打印每个标签的文本内容。

案例

案例1:解析天气预报

假设我们需要获取某个城市的天气预报信息,我们可以使用Python爬虫和BeautifulSoup库来解析相关网页内容。以下是一个简单的例子:

python">from bs4 import BeautifulSoup

import requests

# 发起请求,获取天气预报网页内容

url = 'https://www.xxxx.com'

response = requests.get(url)

html_content = response.text

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'html.parser')

# 解析天气预报网页内容

forecast_tag = soup.find('div', attrs={'class': 'forecast'})

print('天气预报:', forecast_tag.text)

在上面的例子中,我们使用requests模块发起请求,获取天气预报网页的HTML内容。然后,我们使用BeautifulSoup()方法创建一个BeautifulSoup对象,传入网页的HTML内容和解析器类型。接下来,我们使用find()方法查找class属性为"forecast"的<div>标签,并使用text属性获取标签内的文本内容,即天气预报信息。

案例2:解析新闻标题和链接

假设我们需要获取某个新闻网站上的新闻标题和链接,我们同样可以使用Python爬虫和BeautifulSoup库来解析相关网页内容。以下是一个简单的例子:

python">from bs4 import BeautifulSoup

import requests

# 发起请求,获取新闻网页内容

url = 'https://www.xxxx.com'

response = requests.get(url)

html_content = response.text

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'html.parser')

# 解析新闻网页内容

news_tags = soup.find_all('a', attrs={'class': 'news-link'})

for news_tag in news_tags:

title = news_tag.text

link = news_tag['href']

print('标题:', title)

print('链接:', link)

在上面的例子中,我们使用requests模块发起请求,获取新闻网页的HTML内容。然后,我们使用BeautifulSoup()方法创建一个BeautifulSoup对象,传入网页的HTML内容和解析器类型。接下来,我们使用find_all()方法查找class属性为"news-link"的<a>标签,并使用循环遍历打印每个标签的标题和链接信息。

练习题:

- 编写一个爬虫程序,从某个在线商城的首页提取热门商品的名称和价格信息。

- 编写一个爬虫程序,从某个新闻网站的首页提取新闻标题、发布时间和摘要信息。

- 尝试使用CSS选择器来解析网页内容,将以上案例中的查找标签的代码改写成使用CSS选择器的方式。

- 尝试使用正则表达式来解析网页内容,提取符合特定模式的信息。

- 尝试使用BeautifulSoup库的其他功能,如处理XML文档、修复不完整的HTML等。

以上练习题可以帮助你进一步练习和掌握Python爬虫解析网页内容的技巧和方法。通过不断练习和实践,你可以逐渐提升自己的爬虫能力,并应用到更广泛的领域中。

除了上述的基本用法,BeautifulSoup库还提供了许多其他的方法和功能,用于处理不同的解析场景。例如,我们可以使用CSS选择器来定位标签,使用正则表达式来匹配内容等等。这些功能使得BeautifulSoup库在解析网页内容时非常灵活和强大。

Python爬虫解析网页内容是非常有用的技能。通过使用BeautifulSoup库,我们可以方便地解析HTML和XML文档,提取网页中的信息。无论是进行数据采集、信息抓取还是网页分析,都可以使用Python爬虫和BeautifulSoup库来解析网页内容,帮助我们更好地获取和利用网页中的有价值信息。