在互联网时代,爬虫技术扮演着重要的角色,它能够帮助我们收集和分析大量的数据。然而,对于那些采用动态加载技术的网站来说,传统的爬虫技术可能无法很好地处理这些页面。本文将介绍如何使用Python爬虫来处理动态加载页面,以及如何利用Selenium和Scrapy这两个强大的工具来实现这一目标。

1. 什么是动态加载页面?

在传统的网页中,页面的内容是在服务器端生成的,并在浏览器中直接显示。但是,随着JavaScript技术的发展,越来越多的网站开始采用动态加载页面的方式。动态加载页面是指页面的内容并不是在服务器端直接生成,而是通过JavaScript代码在客户端生成和加载。这种方式可以使网页更加动态和交互,但也给爬虫带来了挑战。

2. 传统爬虫的局限性

传统的爬虫工具如urllib和requests在处理动态加载页面时会遇到一些问题。这些工具只能获取服务器返回的静态HTML内容,而无法获取通过JavaScript动态生成的内容。因此,当我们使用这些工具爬取一个动态加载页面时,往往只能获取到页面的骨架结构,而无法获取到完整的内容。

3. 使用Selenium解决动态加载问题

Selenium是一个流行的自动化测试工具,可以模拟用户在浏览器中的操作。利用Selenium,我们可以完全加载并运行页面上的所有JavaScript代码,从而获取到完整的动态页面内容。Python中有一个强大的Selenium库,可以很好地与Scrapy这个爬虫框架结合使用。

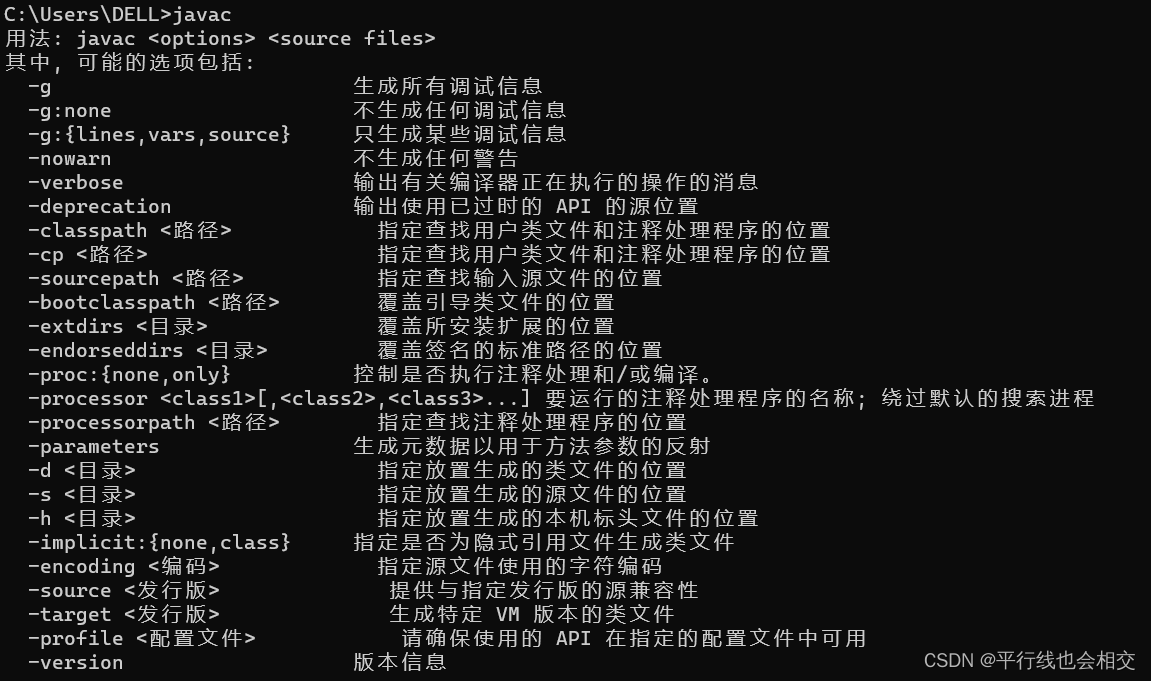

在使用Selenium时,我们需要首先安装浏览器对应的WebDriver。WebDriver是一个控制浏览器的工具,它可以模拟用户在浏览器中的操作。根据你使用的浏览器和操作系统,你可以下载相应的WebDriver,并将其配置到你的系统环境变量中。

接下来,让我们看一个简单的示例代码,演示如何使用Selenium和Scrapy来爬取一个动态加载页面:

python">import scrapy

from scrapy_selenium import SeleniumRequest

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://www.example.com']

def start_requests(self):

for url in self.start_urls:

yield SeleniumRequest(url=url, callback=self.parse)

def parse(self, response):

# 提取页面数据

data = response.css('h1::text').get()

yield {'data': data}

在这个示例中,我们定义了一个Spider类,设置了要爬取的起始URL。然后,在start_requests方法中,我们使用SeleniumRequest来发送请求,并通过回调函数指定了解析响应的方法。在parse方法中,我们使用Scrapy的选择器来提取页面数据,并通过yield语句返回结果。

使用上述代码,你可以根据需要修改URL和选择器,以爬取你所需的动态加载页面的数据。

4. 动态加载页面的常见问题及解决方案

在处理动态加载页面时,我们可能会遇到一些常见的问题,例如页面加载过慢、页面需要登录、页面使用了Ajax等。下面是一些常见问题的解决方案:

-

页面加载过慢:有些动态加载页面可能比较复杂,加载时间较长。为了应对这个问题,我们可以设置适当的等待时间来确保页面完全加载。Selenium提供了一些等待条件,可以根据需要来设置等待时间。

-

页面需要登录:有些网站为了保护用户的隐私,需要用户登录后才能访问内容。对于这种情况,我们可以使用Selenium模拟用户登录,并在登录成功后再进行爬取操作。

-

页面使用了Ajax:Ajax是一种在页面上进行异步通信的技术,它可以在不刷新整个页面的情况下更新部分内容。对于使用了Ajax的页面,我们可以使用Selenium模拟用户的操作,触发Ajax请求,并等待响应完成后再进行数据提取。

5. 结语

动态加载页面在现代网站中越来越常见,传统的爬虫工具可能无法很好地处理这些页面。通过使用Selenium和Scrapy这两个强大的工具,我们可以很好地处理动态加载页面,并获取到完整的内容。通过这篇文章,我们希望能够帮助你理解动态加载页面的原理,并学会如何使用Python爬虫来处理这些页面。希望你能够通过这些技术,更好地应对爬取动态加载页面的挑战,实现你的数据采集目标。

参考文献:

- Scrapy官方文档

- Selenium官方文档

- Selenium with Python