Requests-get方法使用

- 打开网页

- 使用代码获取页面内容

- 查看结果

- 页面格式修改

- 爬取书名

- 完整代码以及注释

- 代码

- 注释

- 翻页查询所有

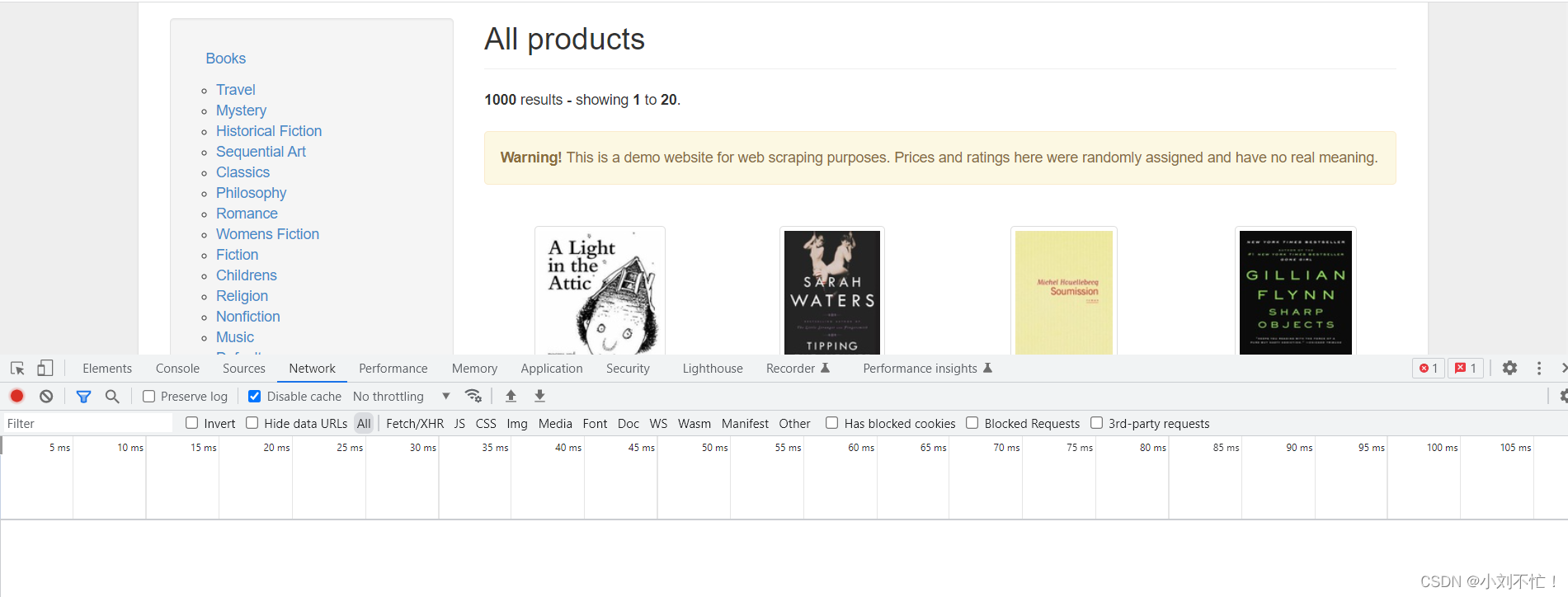

以https://books.toscrape.com/网站为例:

打开网页

先把网页打开,然后右键检查,找到网络一栏,这个时候发现下面是空白,什么也没有:

刷新一下就好了,刷新之后:

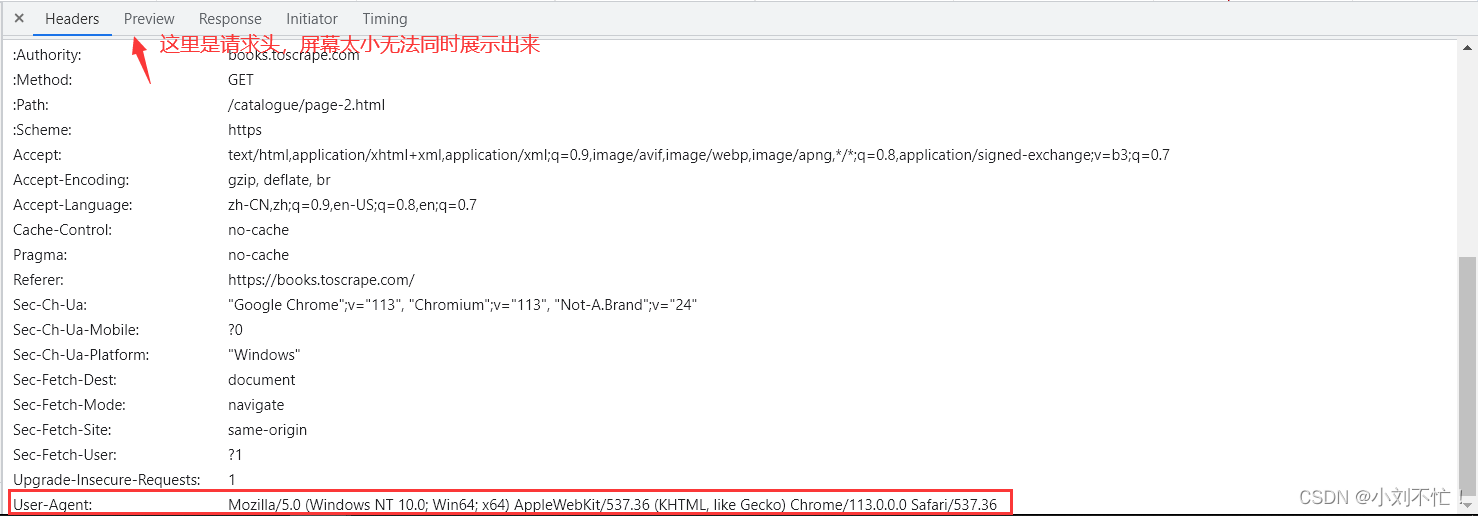

点击第一个进行查看:

可以看到请求方法是"GET"方法,请求的URL也可以看到。

页面的最下方可以发现页面不止一页,点击到下一页并且继续检查页面:

现在使用相同的格式,输入"https://books.toscrape.com/catalogue/page-1.html"进行查看,发现回到了首页。一般第一页就是首页,所以后面的路径也不会加上/catalogue/page-2.html,可以多看几个页面就会发现。

使用代码获取页面内容

python">headers = {

"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/113.0.0.0 Safari/537.36"

}

首先要添加爬虫的头部,因为很多页面对爬虫具有反爬的限制,加上头部之后可以模拟正常的浏览器请求,成功几率更高。这一部分在要访问的页面的请求头部分:

python">url = "https://books.toscrape.com/catalogue/page-1.html"

这一部分声明要访问的网址。

python">responce = requests.get(url,headers=headers).text

把这一部分拆解开:

requests.get(url,headers=headers):带着相应的请求头、以GET方式、访问上面的URL。

requests.get(url,headers=headers).text:将上述内容以文本的方式进行返回。

responce = requests.get(url,headers=headers).text:将内容返回给response这个变量。

查看结果

运行之后显示出了相应页面的内容。但格式有点凌乱,可以使用某些方法进行调整。

页面格式修改

这个时候就要引出BeautifulSoup这个库。BeautifulSoup是一个Python库,用于从HTML和XML文档中提取数据。它提供了一种简单和灵活的方式来解析和遍历这些文档,使得提取特定信息变得更加方便。

python">soup = BeautifulSoup(responce,"html.parser")

这一步的意义是将获取的网页内容(响应文本)使用BeautifulSoup进行解析,以便能够方便地提取和操作其中的数据。如果没有这一步,那么无法使用BeautifulSoup的功能来解析网页内容。在没有进行解析的情况下,你将只是得到一个纯文本的响应内容,难以直接提取所需的特定数据。你将不得不手动处理响应内容来查找、提取所需的信息,这是非常繁琐和容易出错的。

现在进行print(soup)会发现页面格式简洁了很多。

语法解释:

response: 这是一个必需的参数,表示要解析的文档内容。在这个例子中,response是通过发送HTTP请求获取的网页内容,也就是服务器返回的响应文本。它是一个字符串类型的变量,包含了HTML文档的内容。

“html.parser”: 这是第二个参数,它指定了使用的解析器。在这种情况下,使用的是Python内置的HTML解析器,称为"html.parser"。该解析器是BeautifulSoup库的一个组成部分,可以将HTML文档转换为解析树,以便进行进一步的处理和提取。

其他可选的解析器还有"lxml"和"html5lib"。它们都是第三方库,具有不同的特性和性能。选择合适的解析器取决于你的需求和环境。

综上所述,BeautifulSoup(response, “html.parser”)中的两个参数分别表示要解析的文档内容和使用的解析器类型。

爬取书名

使用爬虫肯定是对内容进行爬取,接下来对书名进行爬取。

思路大概分为几步:相应页面的URL、请求头的配置、页面内容的查看、代码参数的配置。

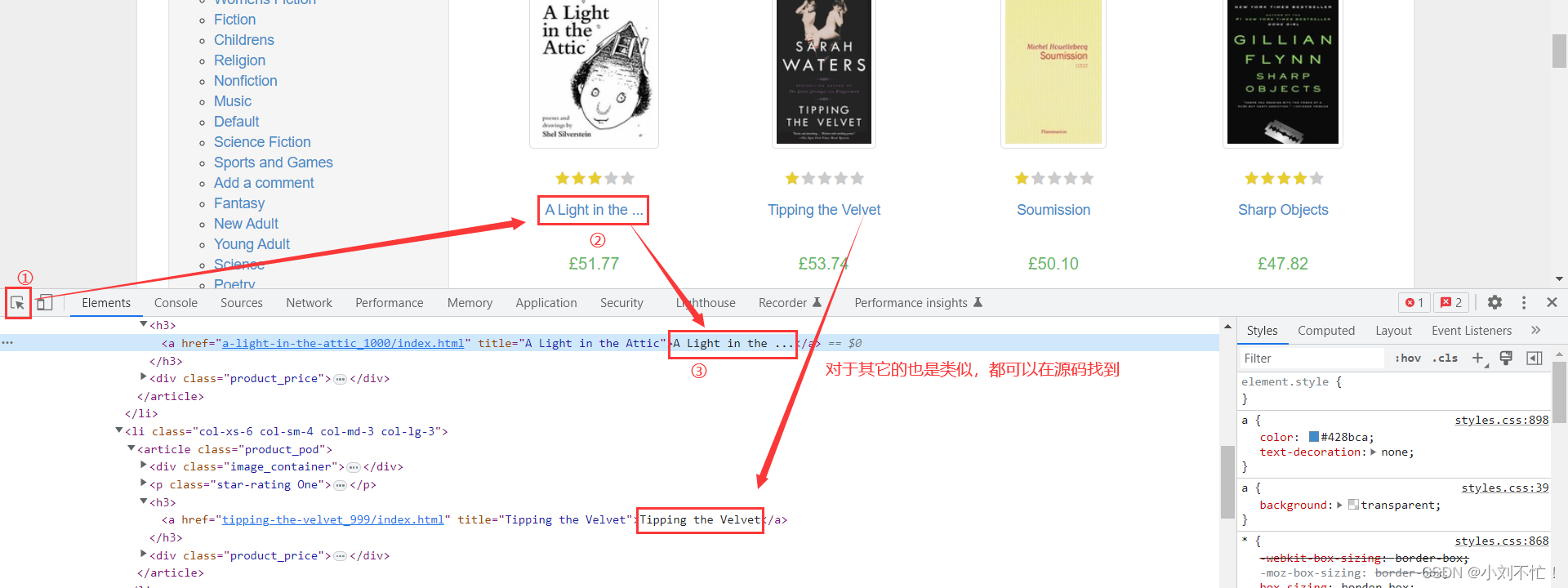

URL以及请求头都已经配置完毕了,接下来对页面内容进行查看,查看书名的地方都有什么特点:

可以发现,外部都有一个h3,然后内部被a标签给包围住了,接下来看代码:

python">soup = BeautifulSoup(responce,"html.parser")

all_title = soup.findAll("h3")

对soup中的所有内容进行搜索,搜索其中包含在"h3"标签中的内容,查看输出:

可以发现,确实输出了"h3"标签中的内容,但是其中的内容并不是我们都想要的,接下来还要进行过滤,看代码:

python">all_title = soup.findAll("h3")

for i in all_title:

title = i.find("a")

print(title)

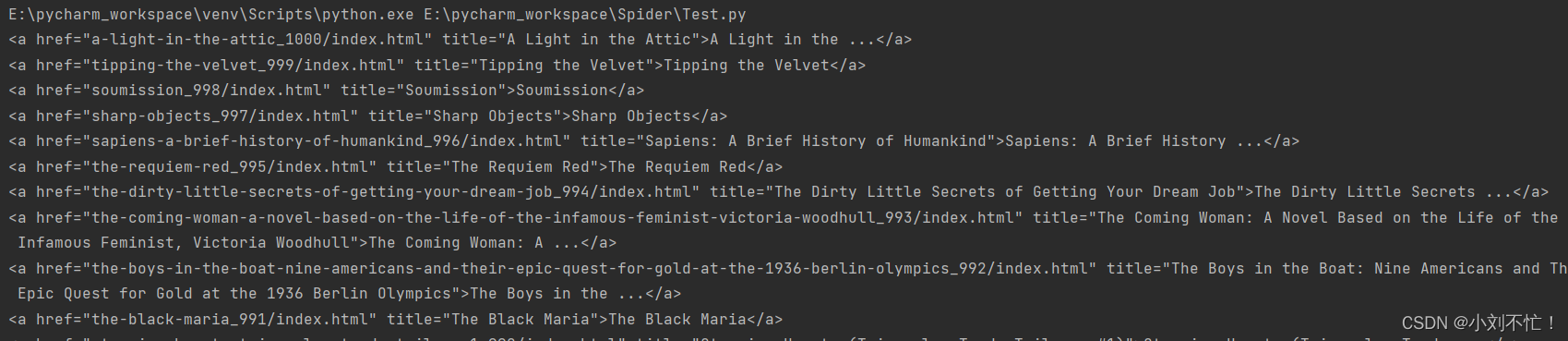

现在对每一个"h3"标签中的内容进行遍历,然后找到其中"a"标签中的内容,查看输出:

针对于"a"标签中的内容,我们不想要html中的标签,只想要html中的文本,所以继续加参数,看代码:

python">all_title = soup.findAll("h3")

for i in all_title:

title = i.find("a")

print(title.string)

这里对于最后的print进行了限制,输出title的string类型,也就是只要其中的文本类型,查看输出:

可以发现,只输出了书名,这个效果也正是我们想要的。

完整代码以及注释

代码

python">from bs4 import BeautifulSoup

import requests

headers = {

"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/113.0.0.0 Safari/537.36"

}#请求头改成自己的

url = "https://books.toscrape.com/catalogue/page-1.html"

responce = requests.get(url,headers=headers).text

soup = BeautifulSoup(responce,"html.parser")

all_title = soup.findAll("h3")

for i in all_title:

title = i.find("a")

print(title.string)

注释

-

from bs4 import BeautifulSoup: 导入BeautifulSoup库,这是为了使用其中的解析和提取功能。 -

import requests: 导入requests库,这是为了发送HTTP请求获取网页内容。 -

headers = {...}: 定义了一个字典类型的变量headers,其中包含了请求头信息。这个请求头信息中设置了User-Agent字段,模拟浏览器发送请求。 -

url = "https://books.toscrape.com/catalogue/page-1.html": 定义了要爬取的目标网页的URL地址。 -

response = requests.get(url, headers=headers).text: 发送HTTP GET请求到指定的URL,并获取响应对象。.text将响应内容以文本形式返回。将获取到的响应文本赋值给response变量。 -

soup = BeautifulSoup(response, "html.parser"): 使用BeautifulSoup库将获取到的响应文本进行解析,创建一个BeautifulSoup对象。传入参数response作为要解析的文档内容,以及解析器类型"html.parser"。 -

all_title = soup.findAll("h3"): 使用BeautifulSoup对象的findAll方法,查找所有<h3>标签,并将结果存储在变量all_title中。findAll返回一个列表,其中包含了所有匹配的标签。 -

for i in all_title:: 对于all_title列表中的每个元素进行迭代。 -

title = i.find("a"): 在当前迭代的<h3>标签中,使用find方法查找第一个<a>标签,并将结果存储在变量title中。 -

print(title.string): 打印title标签的文本内容,即书籍的标题。使用.string获取标签内的文本。

这段代码的作用是从指定的网页中爬取书籍标题信息,并将其打印出来。它使用requests库发送HTTP请求获取网页内容,然后使用BeautifulSoup库解析网页并提取所需信息。最后通过循环打印出每个书籍的标题。

翻页查询所有

放到下一篇详细进行介绍。