网络爬虫开发实战源码:https://github.com/MakerChen66/Python3Spider

原创不易,本文禁止抄袭、转载,多年爬虫实战开发经验总结,侵权必究!

目录

一、正则表达式引入

什么是正则表达式?

正则表达式是处理字符串的强大工具,有属于自己的语法结构,实现字符串的检索、替换、匹配验证都不在话下。对于爬虫来说,从HTML里提取想要的信息就非常方便了

正则表达式适用情况

网站开发、爬虫开发、游戏开发、数据库开发等,总言之,只要包含有字符串,就能使用正则表达式

正则表达式导入

正则表达式在Python中有自带的标准库re,不用安装,只需导入即可

python">import re

二、正则表达式使用

实例引入

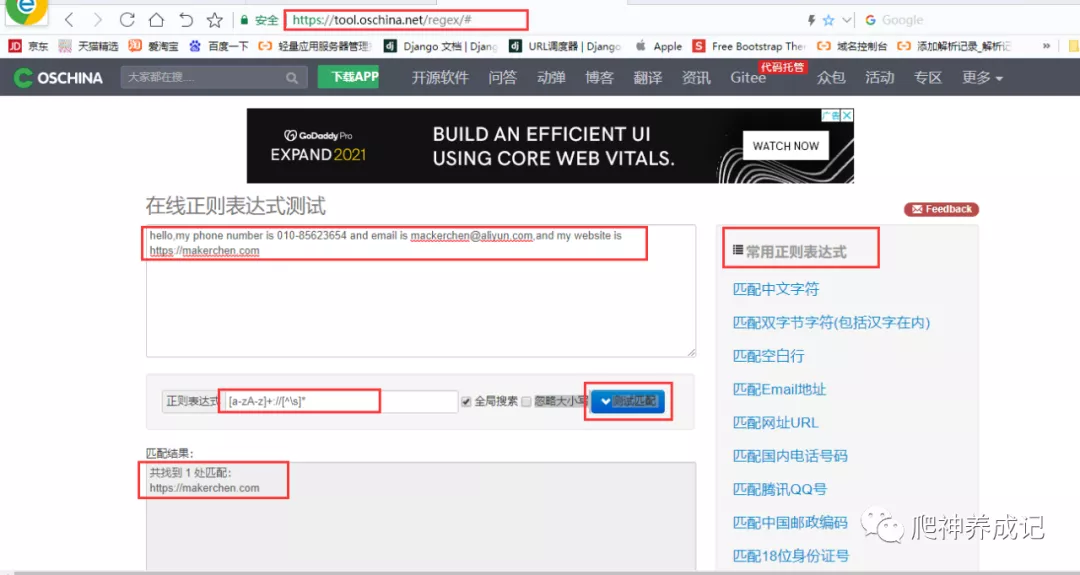

打开开源中国提供的在线正则表达式测试网站:

https://tool.oschina.net/regex/

输入待匹配的字符,然后选择常用的正则表达式或自己写,就可以得出相应的匹配结果了。例如,这里输入待匹配的文本如下:

python">hello,my phone number is 010-85623654 and email is mackerchen@aliyun.com,and my website is https://makerchen.com

这段字符串包含了电话号码、邮箱和URL,接下来就用正则表达式将其提取出来,下如图:

在网页右侧选择“匹配网址URL”,就可以看到下方出现了文本中的URL。如果选择“匹配Email地址”,就可以看到下方出现了文本中的E-mail

这些都是运用了正则表达式匹配,也就是用一定的规则将特定的文本提取出来。比如URL开头是协议类型,然后是冒号加双斜线,最后是域名加路径。另外,电子邮件开头是一段字符串,然后是一个@符号,最后是某个域名,这是有特定的组成格式的

对于URL来说,可以用下面的正则表达式匹配:

python">[a-zA-z]+://[^\s]*

用这个正则表达式去匹配一个字符串,如果这个字符串中包含类似URL的文本,那就会被提取出来

这里面都是有特定的语法规则的。比如a-z代表匹配任意的小写字母,\s表示匹配任意的空白字符,而上面的^\s表示匹配非空白字符,等于\S,*就代表匹配前面的字符任意多个

下表列出了常用的匹配规则:

| \w | 匹配字母、数字及下划线 |

|---|---|

| \W | 匹配不是字母、数字及下划线的字符 |

| \s | 匹配任意空白字符,等价于[\t\n\r\f]以及^\S |

| \S | 匹配任意非空字符,等价于^\s |

| \d | 匹配任意数字,等价于[0-9] |

| \D | 匹配任意非数字的字符 |

| \A | 匹配字符串开头 |

| \Z | 匹配字符串结尾,如果存在换行,只会匹配换行前的结束字符串 |

| \z | 匹配字符串结尾,如果存在换行,同时还会匹配换行符 |

| \G | 匹配最后匹配完成的位置 |

| \n | 匹配一个换行符 |

| \t | 匹配一个制表符 |

| ^ | 匹配一行字符串的开头 |

| $ | 匹配一行字符串的结尾 |

| . | 匹配任意字符,除了换行符,当re.DOTALL标记被指定时,则可以匹配包括换行符的任意字符 |

| […] | 用来表示一组字符,单独列出,比如[amk]匹配a、m或k |

| [^…] | 不在[]中的字符,比如[^abc]匹配除了a、b、c之外的字符 |

| * | 匹配0个或多个表达式 |

| + | 匹配0个或多个表达式 |

| ? | 匹配0个或1个前面的正则表达式定义的片段,非贪婪方式 |

| {n} | 精确匹配n个前面的表达式,比如\d{10}表示匹配10个数字 |

| {n,m} | 匹配n到m次由前面正则表达式定义的片段,贪婪方式 |

| a | b |

| () | 匹配括号内的表达式,也表示一个组 |

看完之后,可能会有点晕晕的,不用担心,后面会详细讲解常见规则的用法

注意:正则表达式不是Python独有的,在其他编程语言也可以使用,只是Python的re库提供了整个正则表达式的实现。同样,爬虫也可以用其他编程语言实现,比如java,但是Python提供的爬虫库比其他编程语言要丰富的多

三、匹配方法

3.1 match()

先介绍第一个常用的匹配方法—match(),有两个形参,分别是正则表达式以及要匹配的字符串

match()方法从字符串开头位置匹配正则表达式,如果匹配成功就返回结果,否则返回None,示例如下:

python">import re

content = 'Hello 123 4567 World_This is a Regex Demo'

print(len(content))

result = re.match('^Hello\s\d\d\d\s\d{4}\s\w{10}', content)

print(result)

print(result.group())

print(result.span())

输出结果如下:

python">41

<_sre.SRE_Match object; span=(0, 25), match='Hello 123 4567 World_This'>

Hello 123 4567 World_This

(0, 25)

(^Hello\s\d\d\d\s\d{4}\s\w{10})

用上面这个正则表达式来匹配这个长字符串。开头的^是匹配字符串的开头,也就是以Hello开头;然后\s匹配空白字符;\d匹配数字,3个\d匹配123;然后再写1个\s匹配空格;后面还有4567,我们其实可以依然用4个\d来匹配,但是这么写比较烦琐,所以后面可以跟{4}以代表匹配前面的规则4次,也就是匹配4个数字;然后后面再紧接1个空白字符,最后\w{10}匹配10个字母及下划线。我们注意到,这里其实并没有把目标字符串匹配完,不过这样依然可以进行匹配,只不过匹配结果短一点而已

从打印输出结果,可以看到结果是SRE_Match对象,这证明成功匹配。该对象有两个方法:group()方法可以输出匹配到的内容,结果是Hello 123 4567 World_This,这恰好是正则表达式规则所匹配的内容;span()方法可以输出匹配的范围,结果是(0, 25),这就是匹配到的结果字符串在原字符串中的位置范围

3.2 search()

前面说过match()方法是从字符串的开头开始匹配的,该匹配方法一旦开头不匹配,整个匹配就会失败。这里有另外一个方法search(),它在匹配时会扫描整个字符串,然后返回第一个成功匹配的结果,如果搜索完了还没有找到就返回None

python">import re

content = 'Extra stings Hello 1234567 World_This is a Regex Demo Extra stings'

result = re.search('Hello.*?(\d+).*?Demo', content)

print(result)

输出结果如下:

python"><_sre.SRE_Match object; span=(13, 53), match='Hello 1234567 World_This is a Regex Demo'>

为了匹配方便,我们尽量使用search()方法。如果把上面代码的search改为match,输出结果就为None

3.3 findall()

前面所说的search()方法会返回第一个符合正则表达式的内容,但如果我们想要获取匹配正则表达式的所有内容,就需要用到findall()方法了,示例如下:

python">import re

html = '''<div id="songs-list">

<h2 class="title">经典老歌</h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2">一路上有你</li>

<li data-view="7">

<a href="/2.mp3" singer="任贤齐">沧海一声笑</a>

</li>

<li data-view="4" class="active">

<a href="/3.mp3" singer="齐秦">往事随风</a>

</li>

<li data-view="6"><a href="/4.mp3" singer="beyond">光辉岁月</a></li>

<li data-view="5"><a href="/5.mp3" singer="陈慧琳">记事本</a></li>

<li data-view="5">

<a href="/6.mp3" singer="邓丽君">但愿人长久</a>

</li>

</ul>

</div>'''

我们想要获取上面HTML文本中所有a节点的超链接、歌手和歌名,就可以将search()方法换成findall()方法,返回结果是列表类型,需要遍历一下来获取列表中每一组的内容,代码如下:

python">results = re.findall('<li.*?href="(.*?)".*?singer="(.*?)">(.*?)</a>', html, re.S)

print(results)

print(type(results))

for result in results:

print(result)

print(result[0], result[1], result[2])

输出结果如下:

可以看到,findall()方法返回的类型是“list”,列表中的每个元素都是元组类型,用对应的索引取出即可

3.4 sub()

我们使用正则表达式提取信息,有时候还需要修改文本,这时就可以用到sub()方法,它的作用与replace()方法相同,不过用法不同并且使用replace()方法更加繁琐,所以推荐使用sub()方法。示例如下:

python">import re

content = '54aK54yr5oiR54ix5L2g'

content = re.sub('\d+', '', content)

print(content)

sub()方法有三个形参,第一个是正则表达式,表示要匹配的内容,第二个参数为要替换成的字符串(可以为空),第三个参数是原字符串。上面表示将数字替换成空,也就是将数字去掉

输出结果如下:

python">aKyroiRixLg

3.5 compile()

前面所讲的方法都是用来处理字符串的方法,最后介绍一下compile()方法,该方法可以将正则表达式字符串转换成正则表达式对象,以便在后面的匹配中复用

示例如下:

python">import re

content1 = '2016-12-15 12:00'

content2 = '2016-12-17 12:55'

content3 = '2016-12-22 13:21'

pattern = re.compile('\d{2}:\d{2}')

result1 = re.sub(pattern, '', content1)

result2 = re.sub(pattern, '', content2)

result3 = re.sub(pattern, '', content3)

print(result1, result2, result3)

这里有3个日期,我们想分别将3个日期中的时间去掉,这时可以借助sub()方法。该方法的第一个参数是正则表达式,但是这里没有必要重复写3个同样的正则表达式,此时可以借助compile()方法将正则表达式编译成一个正则表达式对象,以便复用

输出结果如下:

python">2016-12-152016-12-172016-12-22

另外,compile()还可以传人修饰符,例如re.S等修饰符,这样在search()、findall()等方法中就不需要额外传了。所以compile()方法可以说是给正则表达式做了一层封装,以便我们更好地复用

四、匹配模式

4.1 匹配目标

在匹配方法中我们用match()方法可以得到匹配到的字符串内容,但是如果想从字符串中提取一部分内容该怎么办呢?就像最前面的实例一样,从一段文本中提取出邮件或电话号码等内容

这里可以使用()括号将想提取的子字符串括起来,()实际上标记了一个子表达式的开始和结取位置,被标记的每个子表达式会依次对应每一个分组,调用group()方法传入分组的索引即可获取提取的结果。示例如下:

python">import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^Hello\s(\d+)\sWorld', content)

print(result)

print(result.group())

print(result.group(1))

print(result.span())

这里我们想把字符串中的1234567提取出来,此时可以将数字部分的正则表达式用()括起来,然后调用了group(1)获取匹配结果

输出结果如下:

python"><_sre.SRE_Match object; span=(0, 19), match='Hello 1234567 World'>

Hello 1234567 World

1234567

(0, 19)

可以看到,我们成功得到了1234567,这里用的是group(1),它与group()有所不同,后者会输出完整的匹配结果,而前者会输出第一个被()包围的匹配结果。假如正则表达式后面还有()包括的内容、那么可以依次用group(2)、group(3)等来获取

4.2 通用匹配

刚才我们写的正则表达式其实比较复杂,出现空白字符我们就写\s匹配,出现数字我们就用\d匹配,这样的工作量非常大。其实完全没必要这么做,因为还有一个万能匹配可以用,那就是.(点星)。其中.(点)可以匹配任意字符(除换行符,(星)代表匹配前面的字符无限次,所以它们组合在一起就可以匹配任意字符了。有了它,我们就不用挨个字符地匹配了

接着上面的例子,我们可以改写一下正则表达式:

python">import re

content = 'Hello 123 4567 World_This is a Regex Demo'

result = re.match('^Hello.*Demo$', content)

print(result)

print(result.group())

print(result.span())

我们将中间部分直接省略,用.*来代替,最后加一个结尾字符串就好了,输出结果如下:

python"><_sre.SRE_Match object; span=(0, 41), match='Hello 123 4567 World_This is a Regex Demo'>

Hello 123 4567 World_This is a Regex Demo

(0, 41)

group()方法输出了匹配的全部字符串,也就是说我们写的正则表达式匹配到了目标字符串的全部内容;span()方法输出(0, 41),这是整个字符串的长度

因此,我们可以使用.*简化正则表达式的书写

4.3 贪婪与非贪婪

使用上面的通用匹配.*时,可能有时候匹配到的并不是我们想要的结果。如下:

python">import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^He.*(\d+).*Demo$', content)

print(result)

print(result.group(1))

这里我们依然想获取中间的数字,所以中间依然写的是(\d+)。而数字两侧由于内容比较杂乱,所以想省略来写,都写成.。最后,组成^He.(\d+).*Demo$,看样子并没有什么同题。我们看下输出结果:

python"><_sre.SRE_Match object; span=(0, 40), match='Hello 1234567 World_This is a Regex Demo'>

7

奇怪的事情发生了,我们只得到了7这个数字,这是怎么回事呢?

这里就涉及一个贪婪匹配与非贪婪匹配的问题了。在贪婪匹配下,.*会匹配尽可能多的字符。正则表达式中,.*后面是\d+,也就是至少一个数字,并没有指定具体多少个数字,因此,.*就尽可能匹配多的字符,这里就把123456匹配了,给\d+留下一个可满足条件的数字7,最后得到的内容就只有数字7了

但这很明显会给我们带来很大的不便。有时候,匹配结果会莫名其妙少了一部分内容。其实,这里只需要使用非贪婪匹配就好了。非贪婪匹配的写法是.*?,多了一个?,那么它可以达到怎样的效果?

我们再用实例看一下:

python">import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^He.*?(\d+).*Demo$', content)

print(result)

print(result.group(1))

我们只是将.转换成.?,就变成了非贪婪匹配。输出结果如下:

python"><_sre.SRE_Match object; span=(0, 40), match='Hello 1234567 World_This is a Regex Demo'>

1234567

此时就可以成功获取1234567了。原因可想而知,贪婪匹配是尽可能匹配多的字符,非贪婪匹配就是尽可能匹配少的字符。当.?匹配到Hello后面的空白字符时,再往后的字符就是数字了,而\d+恰好可以匹配,那么这里.?就不再进行匹配,交给\d+去匹配后面的数字。所以这样.*?匹配了尽可能少的字符,\d+的结果就是1234567了

所以说,在做匹配的时候,字符串中间尽量使用非贪婪匹配,也就是用.?来代替.,以免出现匹配结果缺失的情况

但是这里需要注意,如果匹配的结果在字符串结尾,.*?就有可能匹配不到任何内容了,此时需要改成.*

4.4 修饰符

正则表达式可以包含一些可选标志修饰符来控制匹配的模式。示例如下:

python">import re

content = '''Hello 1234567 World_This

is a Regex Demo

'''

result = re.match('^He.*?(\d+).*?Demo$', content)

print(result.group(1))

和上面的例子相似,我们只是在字符串中加了换行符,正则表达式还是一样的,用来匹配其中的数字。看一下输出结果:

python">AttributeError: 'NoneType' object has no attribute 'group'

运行直接报错,也就是说正则表达式没有匹配到这个字符串,返回结果为None,而我们又调用了group()方法导致AttributeError

那么,为什么加了一个换行符就匹配不到了呢?这是因为,匹配的是除换行符之外的任意字符,当遇到换行符时,.*?就不能匹配了,所以导致匹配失败。这里只需加一个修饰符re.S,即可修正这个错误:

python">result = re.match('^He.*?(\d+).*?Demo$', content,re.S)

这个修饰符的作用是使.匹配包括换行符在内的所有字符。此时输出结果如下:

python">1234567

re.S在网页匹配中经常用到。因为HTML节点经常会有换行,加上它,就可以匹配节点与节点之间的换行了

另外,还有一些修饰符,如下表所示:

| re.I | 使匹配对大小写不敏感 |

|---|---|

| re.L | 本地化识别匹配 |

| re.M | 多行匹配,影响^和$ |

| re.S | 使.匹配包括换行符在内的所有字符 |

| re.U | 根据Unicode字符集解析字符,影响\w、\W、\b、\B |

| re.X | 给予更加灵活的正则表达式格式 |

4.5 转义匹配

正则表达式中定义了许多匹配模式,如.匹配包括换行符在内的所有字符,但是如果目标字符串里面就包含.,那该怎么办呢?

这时就需要用到转义匹配了,如下所示:

python">import re

content = '(百度)www.baidu.com'

result = re.match('\(百度\)www\.baidu\.com', content)

print(result)

当遇到用于正则匹配模式的特殊字符时,在前面加反斜线转义一下即可。这里用.来匹配,输出结果如下:

python"><_sre.SRE_Match object; span=(0, 17), match='(百度)www.baidu.com'>

可以看到,这里成功匹配到了原字符串

这些是写正则表达式常用的匹配模式,掌握它们对写正则表达式匹配非常有帮助

4.6 结语

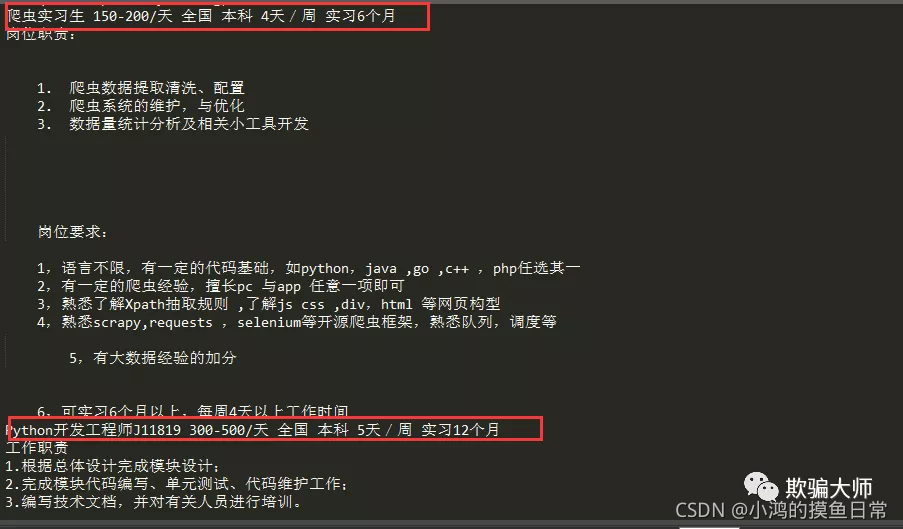

到此为止,正则表达式的基本用法就介绍完了,后面会通过具体的实例来讲解正则表达式的用法,包括使用正则表达式爬取猫眼电影数据、实习僧数据等。请看Web爬虫对应的实战文章

五、原文链接

本人原创公众号原文链接:阅读原文

原创不易,如果觉得有点用,希望可以随手点个赞,拜谢各位老铁!

六、作者Info

作者:小鸿的摸鱼日常,Goal:让编程更有趣!

原创微信公众号:『小鸿星空科技』,专注于算法、爬虫,网站,游戏开发,数据分析、自然语言处理,AI等,期待你的关注,让我们一起成长、一起Coding!

转载说明:本文禁止抄袭、转载 ,违者必究!